火热的文图生成模型Stable Diffusion学习笔记

一、Stable Diffusion介绍

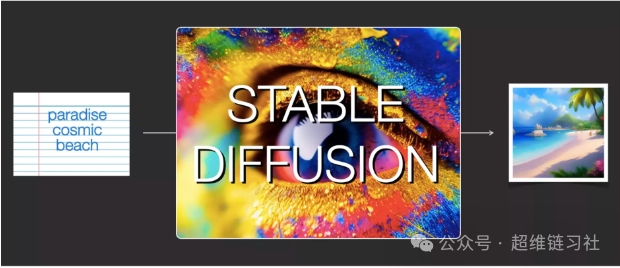

Stable Diffusion是一种在计算机科学和数据分析领域广泛使用的算法,同时也是一个由多个组件和模型组成的系统,主要用于图像处理、信号处理、计算机视觉和机器学习等方面。在图像处理中,Stable Diffusion的主要思想是将数据进行扩散处理,以达到数据平滑的效果,同时可以消除一些噪音和不必要的细节。在机器学习和计算机视觉领域中,Stable Diffusion可以通过对特征进行扩散处理,使得特征之间的差异得到减小,从而实现特征的平滑和降维等效果。

特别地,Stable Diffusion是stability.ai开源的图像生成模型,能够进行文生图(txt2img)和图生图(img2img)等图像生成任务,其效果和影响被认为是AI图像生成领域的一大突破。在Stable Diffusion之前,计算机视觉和机器学习方面最重要的突破是GAN(Generative Adversarial Networks 生成对抗网络),然而GAN在经历了一段蓬勃发展后开始暴露出一些瓶颈和弊病。Stable Diffusion的出现则解决了这些问题,并为工业界、投资界、学术界以及竞赛界都注入了新的AI想象空间。

Stable Diffusion包含一个文本理解组件,用于将文本信息翻译成数字表示,以捕捉文本中的语义信息。模型的输入为一个文本字符串,输出为一个数字列表,用来表征文本中的每个单词或token。然后这些信息会被提交到图像生成器中,其内部也包含多个组件。

作为一个完全开源的项目,Stable Diffusion不仅包含了模型、代码和训练数据,还有相关的论文等。这使得其快速构建了强大繁荣的上下游生态,包括AI绘画社区、基于SD的自训练模型、丰富的辅助AI绘画工具与插件等,吸引了越来越多的AI绘画爱好者加入其中,与AI行业从业者一起推动AIGC行业的发展与普惠。

总之,Stable Diffusion在图像处理、机器学习、计算机视觉和图像生成等多个领域都有广泛的应用,其开源和可扩展的特性使得它成为当前AI领域的重要研究和应用工具。

二、Stable Diffusion的主要优点:

高质量图像生成:Stable Diffusion可以生成高质量的图像,无论是自然景观、人脸还是艺术作品,它都能捕捉到图像的纹理、形状和细节,生成逼真的图像。

逐步揭示细节:该算法通过逐步添加和减少噪声的方式,逐渐揭示出图像中的细节和形状,使得生成的图像更加真实和清晰。

可控的生成过程:用户可以通过调整扩散参数和逆向过程来控制生成过程的速度和效果,这提供了根据需求和偏好定制图像的灵活性。

在商业应用中的优势:Stable Diffusion可以去除图像中的噪点和干扰,增强图像的清晰度和信息量;使用深度学习技术提高图像的保真度,更好地展示原始图像的细节;同时,其算法准确度较高,有助于保持图像的特征和形态,减少变形或模糊等问题。

然而,Stable Diffusion也存在一些缺点:

牺牲多样性:由于引入了稳定性系数,Stable Diffusion可能在某些情况下牺牲了生成样本的多样性。

生成速度:虽然Stable Diffusion的训练速度较快,但在某些情况下,生成样本的速度可能会变慢。

安装和部署的挑战:由于Stable Diffusion是开源的,需要用户自行安装和部署。这可能对机器的性能要求较高,对于一些用户来说可能是一个挑战。

三、Stable Diffusion的基本原理:

Stable Diffusion的基本原理可以概括为通过神经网络模型对文本进行解码,进而生成具有自然语言风格的图像。其核心步骤包括文本到向量的转换、扩散模型的应用、超分辨率放大以及艺术风格的融合。

首先,Stable Diffusion使用一个新颖的文本编码器(如OpenCLIP),将输入的文本转换为向量表示。这个向量表示能够捕捉文本的语义信息,并与图像空间进行对齐,为后续生成图像提供指导。

接下来,Stable Diffusion利用一个扩散模型。扩散模型是一种生成模型,它可以从训练数据中学习出一个概率分布,并从中采样出新的数据。在这个过程中,Stable Diffusion将一个随机噪声图像逐渐变换为目标图像。这是通过逐步减少噪声的强度,并根据文本编码器的输出调整图像的内容来实现的。

为了得到更高质量的图像,Stable Diffusion还采用了一个超分辨率放大器。这个放大器可以将生成的低分辨率图像放大到更高的分辨率,进一步提升图像的细节和清晰度。

此外,Stable Diffusion还具备艺术风格融合的能力。它可以将不同的艺术风格(如油画、水彩、动漫等)融合到生成的图像中,使得生成的图像更具艺术性和多样性。

四、Stable Diffusion组成部分

Stable Diffusion主要由三个核心组件组成:文本编码器(Text Encoder)、潜在扩散模型(Latent Diffusion Model)以及解码器(Decoder)。

文本编码器(Text Encoder):

文本编码器的作用是将输入的文本信息转化为向量表示,即嵌入(embedding)。这个嵌入向量能够捕捉文本的语义信息,为后续生成图像提供指导。这个组件通常是一个预训练的模型,如Transformer模型,它能够有效地处理文本数据并提取关键信息。潜在扩散模型(Latent Diffusion Model):

潜在扩散模型是Stable Diffusion的核心部分,它负责根据文本编码器的输出生成图像。这个模型由两个主要部分组成:变分自编码器(VAE)和U-Net。变分自编码器(VAE):VAE编码器将图像从像素空间压缩到一个更小维度的潜在空间,捕捉图像的更本质的语义含义。这个潜在空间是模型进行后续操作的基础,它去除了图像中的冗余信息,使得模型能够更高效地处理图像数据。

U-Net:U-Net是一个卷积神经网络,它能够从潜在空间重建图像,并去除高斯噪声。通过U-Net,模型能够根据文本编码器的输出在潜在空间中生成对应的图像信息。

解码器(Decoder):

解码器的作用是将潜在扩散模型生成的图像信息解码为最终的图像输出。它接受U-Net的输出,并将其转换为像素空间的图像。解码器确保生成的图像在视觉上符合文本描述,并且具有高质量的细节和清晰度。

五、Stable Diffusion的运行最低配置要求

Stable Diffusion的运行最低配置要求主要包括以下几个方面:

CPU:建议使用Intel i5 2.8 GHz或更高版本的CPU,以确保程序能够顺畅运行。

内存:最低配置要求为8GB的内存。然而,为了提高运行效果和效率,建议使用16GB或以上的内存。在内存较小的情况下,可能需要调高虚拟内存以容纳模型文件。

显卡:显卡对于Stable Diffusion的运行至关重要。最低配置要求为Nvidia Geforce GTX或AMD Radeon HD 7770或更高版本的显卡,显存至少为2GB。为了获得更好的性能和体验,建议显存不少于4GB,推荐8GB以上。请注意,由于需要用到CUDA加速,Nvidia显卡通常具有较好的支持,而AMD显卡的速度可能会稍慢一些。

硬盘:硬盘空间方面,最低要求为30GB的可用空间,建议准备40GB以上的空间,并最好是固态硬盘(SSD),以提高读写速度。

网络:由于Stable Diffusion在运行过程中可能需要从远程服务器获取数据和模型,因此建议至少具备20 Mbps的网络下载速度和5 Mbps的网络上传速度,以确保稳定的网络连接。

历史文章:

大量请求引起的Nginx 502 Bad Gateway错误的深度解决

Mysql高级用法:从表中按分组排序并取组内第一或者最后的数据行

推荐好工具:ElecTerm 再也不用满世界找xshell/Mobaxterm PoJie版了

ThinkPad重装后续-6步手动添加Git Bash Here到右键菜单

真实案例:从零迁移10+台16C32G腾讯云服务器应用上私有云实战(必坑)

推荐好工具:ElecTerm 再也不用满世界找xshell/Mobaxterm PoJie版了